Inteligencia Artificial podría causar “grandes riesgos para la humanidad”; piden una pausa en su uso

Los sistemas de IA solo se deben desarrollar cuando haya la seguridad de que sus efectos serán positivos y sus riesgos manejables

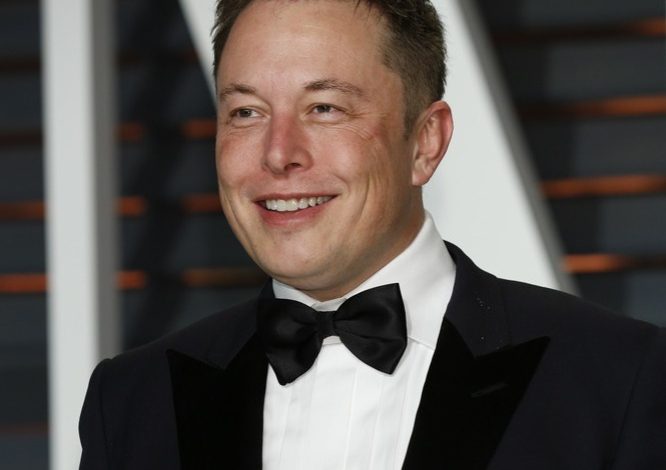

Este miércoles, Elon Musk junto a cientos de expertos en Inteligencia Artificial IA, firmaron un llamado en el que piden pausar por seis meses la investigación de IA más poderosas que ChatGPT4, el modelo de OpenAI.

De acuerdo con la solicitud publicada en el sitio web futureoflife.org, “los sistemas de IA con inteligencia humana-competitiva pueden plantear riesgos profundos para la sociedad y la humanidad”. Esto, basado en una investigación

En el texto afirman que la Inteligencia Artificial avanzada podría representar un cambio importante en la historia de la vida en la Tierra, y que se debe planificar y administrar con sumo cuidado y con los recursos que corresponden. “Desafortunadamente, este nivel de planificación y gestión no está ocurriendo, a pesar de que en los últimos meses los laboratorios de IA han entrado en una carrera fuera de control para desarrollar e implementar mentes digitales cada vez más poderosas que nadie, ni siquiera sus creadores, pueden entender, predecir o controlar de forma fiable”.

Por su parte, el director de Open AI, quien diseñó ChatGPT, Sam Altman, reconoció que tiene “un poco de miedo” de que su creación sea utilizada para “desinformación a gran escala o ciberataques… La empresa necesita tiempo para adaptarse”, declaró recientemente a ABCNews.

¿Deberíamos arriesgarnos a perder el control de nuestra civilización?

Los firmantes de la petición se cuestionan si deben dejar que las máquinas llenen los canales de información con “propaganda y falsedad” o si todos los trabajos se deben automatizar. “¿Deberíamos desarrollar mentes no humanas que eventualmente podrían superarnos en número, ser más inteligentes, obsoletas y reemplazarnos? ¿Deberíamos arriesgarnos a perder el control de nuestra civilización?”, agregan.

Aseguran que los sistemas potentes de IA solo se deben desarrollar cuando haya la seguridad de que sus efectos serán positivos y sus riesgos serán manejables.

“Por lo tanto, hacemos un llamado a todos los laboratorios de IA para que pausen de inmediato durante al menos 6 meses el entrenamiento de los sistemas de IA más potentes que GPT-4 . Esta pausa debe ser pública y verificable, e incluir a todos los actores clave. Si tal pausa no se puede promulgar rápidamente, los gobiernos deberían intervenir e instituir una moratoria”, concluyen.

- Temblor hoy en Colombia de 4.5: este fue el epicentro - 26 de julio de 2024

- Juegos Olímpicos: Despiden a entrenadora por usar drones para espiar los entrenamientos de sus rivales - 26 de julio de 2024

- Confirman primeros fallecimientos por raro virus que se parece al dengue - 26 de julio de 2024